https://arxiv.org/abs/1706.03762

Attention Is All You Need

The dominant sequence transduction models are based on complex recurrent or convolutional neural networks in an encoder-decoder configuration. The best performing models also connect the encoder and decoder through an attention mechanism. We propose a new

arxiv.org

논문의 부록을 내리다 보면 다음처럼 Attention이 무엇인지, 특히 Self-Attention이 무엇인지와 어떻게 작동하는지를 설명해주는 그림이 있어서 이번 포스팅에선 이걸 보면서 간단하게 Attention을 정리해보고자 한다.

https://tiabet0929.tistory.com/45

[NLP Study] - Attention Mechanism이 특별한 이유

사실상 세상을 바꾼 아키텍쳐라고 봐도 무방한 트랜스포머의 어텐션 매커니즘에 대해서 정리해보고자 한다. 참고자료 https://wikidocs.net/22893 15-01 어텐션 메커니즘 (Attention Mechanism) 앞서 배운 seq2se

tiabet0929.tistory.com

첫 번째 그림은 Self-Attention이 이루어지는예시를 보여준다. 현재 상황은 making에 대한 Self-Attention이 이루어지고 있는 상황. 인코더의 총 6개의 layer 중 5번 째 layer에서 작동하는 것을 보여주는 그림이라고 한다. 또한 단어에 칠해져있는 다른 색깔들은 서로 다른 Attnetion head에서 계산된 Attention value임을 의미하는 것 같다. 또한 위의 문장의 Making은 Query, 아래 문장은 Key로써 작용하는 것으로 보인다. 원래 모델에선 Attention Head는 8개, encoding layer는 6개였음을 참고. 확인해보면 단어에 칠해진 색이 8가지 색이다.

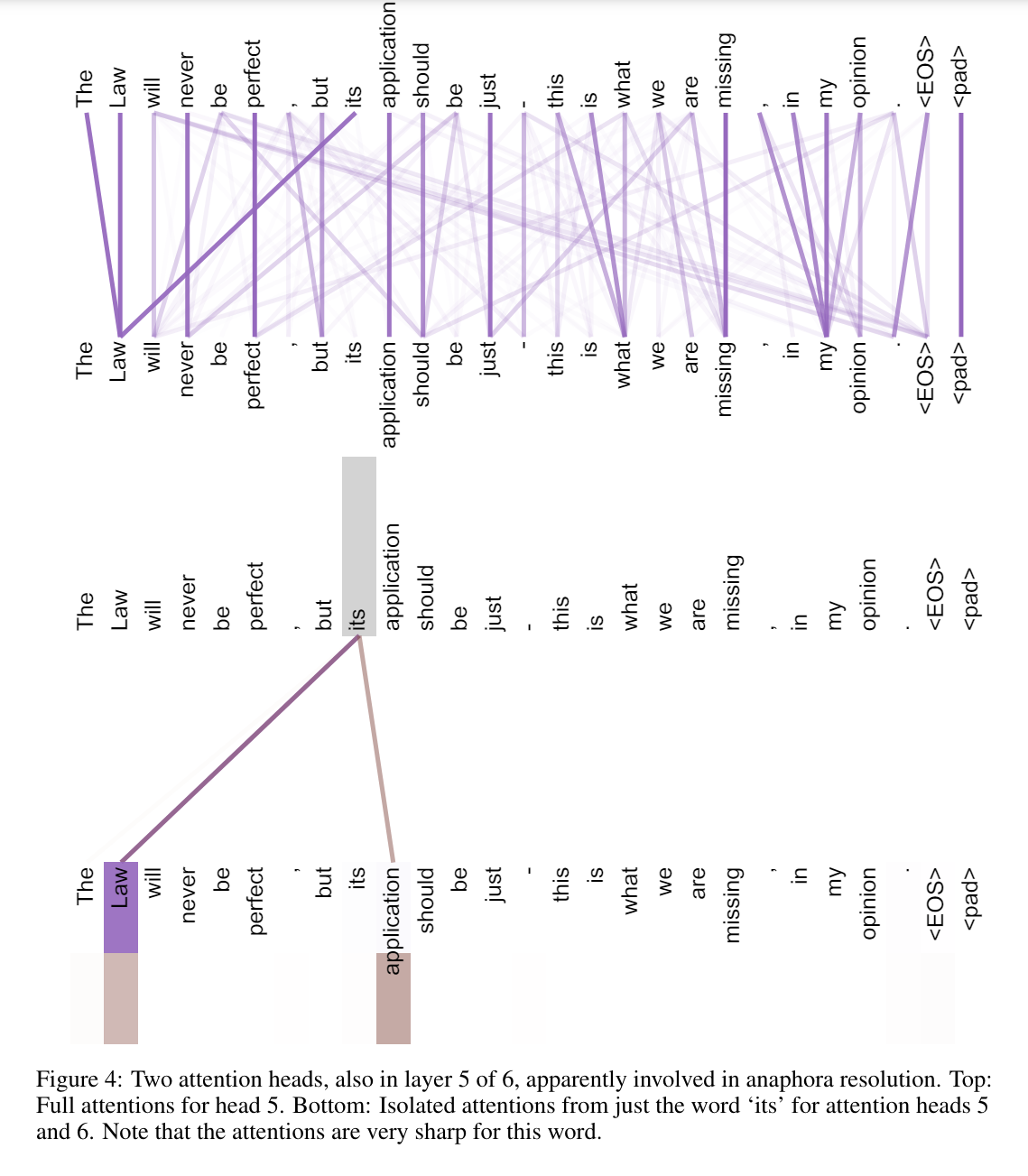

이 그림은 Attention Head의 모습을 보여준다. 위의 Attention head는 Full Attention (모든 단어에 대해 Self-Attention을 진행), 아래의 Attention Head는 its의 Attention만 보여준다고 한다. anaphora resolution이 뭔지 몰라서 찾아봤는데, 언어학적인 용어로써 한글로는 조응해소 라고 한다. 자세히 설명하긴 어렵고 아무튼 it, he, she 등의 대명사로 앞의 문장에 나온 어떤 명사를 가리킬 때 anaphor라는 단어를 사용한다고 한다. 지금 예시에선 its 라는 단어가 무엇을 가리키는지를 Attention 으로 학습하는 과정이라고 해석된다.

이 그림은 각각의 Attention Head가 다르게 작동하여, Attention Head마다 다른 문맥의 의미를 파악한다고 말하는 것이다.

다음 포스팅에선 이 Attention Head가 파이썬으로 어떻게 구현되는지를 정리해보고자 한다.

'NLP > Transformer' 카테고리의 다른 글

| [NLP] Transformer Multi-Head Attention 파이썬으로 정리 (2) | 2025.01.01 |

|---|---|

| [NLP] Transformer의 Attention Head 파이썬으로 정리 (6) | 2024.10.30 |

| [NLP] 트랜스포머 구조 파악하기 (Attention is All You Need) (2) | 2024.06.11 |

| [NLP] Transformer의 Input은 어떻게 Embedding Vector로 변환되나? (0) | 2024.06.06 |

| [NLP] Transformer의 Positional Encoding 정리 (0) | 2024.06.06 |